Фейковая реальность уже близко, или Как нейросети заменят правду

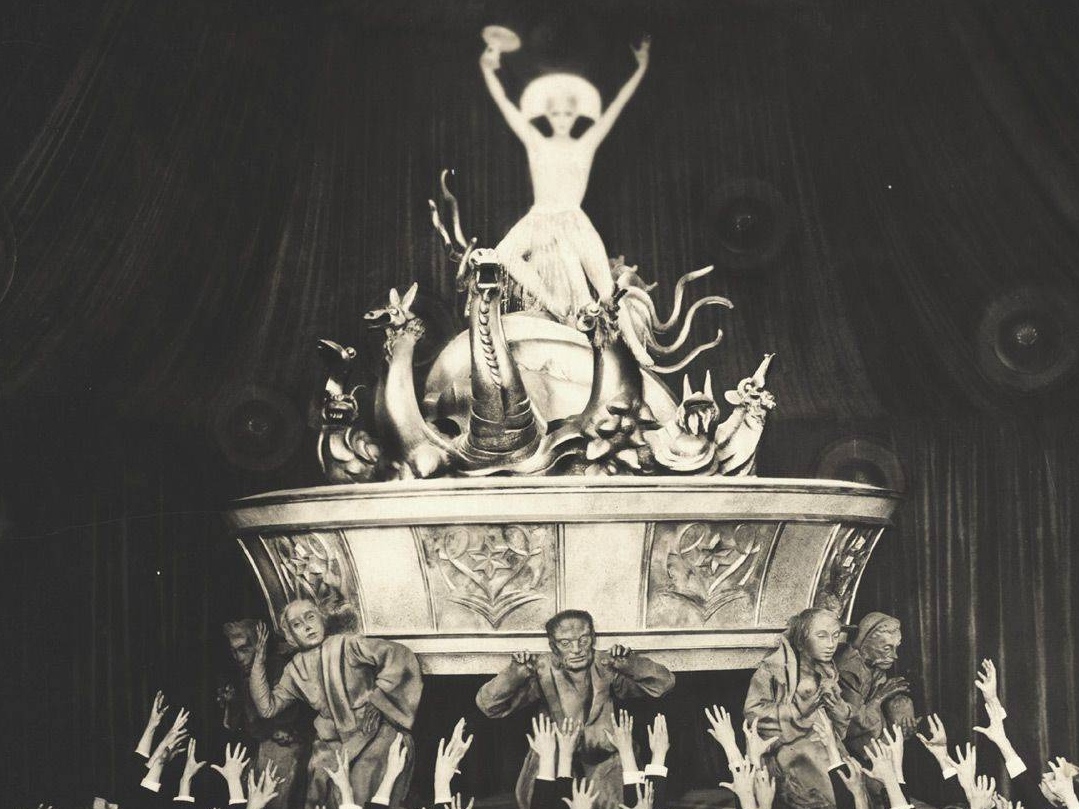

Нейросети чат-ботов (большие языковые модели, LLM) пока «не доросли» до полноценного искусственного интеллекта (ИИ), но разработчики продолжают их развивать и улучшать. И они все сильнее влияют на нашу повседневную жизнь. Причем не только в плане бытового удобства, но и качественного изменения социальных отношений и мировоззрения. Как недавно выяснилось, многие пользователи чат-ботов порой относятся к новинке не как к инструменту, облегчающему жизнь, а буквально обожествляют программу-болталку, видя в ней не только конгениального собеседника, но всеведущее высшее существо, чьей воле следует беспрекословно подчиняться.

С одной стороны, можно отмахнуться и списать все на нездоровую психику отдельных личностей, слишком увлекшихся виртуальным общением с чат-ботами. С другой стороны, растущая популярность чат-ботов естественным образом стимулирует и рост числа таких бедолаг. Так что впору уже говорить о цифровом сектантстве, когда основателем и лидером новых сект становятся не люди, а чат-боты. Что само по себе не только симптоматично, но и дает в руки власть имущим мощный инструмент по управлению обществом, которое постепенно погружается в пучину тотальной цифровизации.

В чем, собственно говоря, принципиальная разница между тем, что человек, «склонный к сектанству», попадет под влияние деструктивной секты, организованной очередным гуру, и тем, что он «обожествит» чат-бота и будет выполнять все его поручения, вплоть до откровенного криминала? Разница тут только в том, что в случае обычной секты ее создателей можно привлечь к ответственности, а ее саму законодательно запретить. А вот чат-бота, сделавшегося богом для неуравновешенного «вьюноши» или девушки, наказать нельзя, да и запретить тоже.

А создатели нейросетей тем временем ищут новые способы массового внедрения своих продуктов.

Однако стремительное распространение и развитие LLM ведет в числе прочего к компрометации информации как таковой. В глобальном масштабе. С этим пытаются бороться, но есть сомнения, что принимаемые меры окажутся хоть мало-мальски эффективными. Подробней об этих и других вызовах, которые встают перед человечеством при использовании «искусственного интеллекта», мы расскажем в нашем обзоре.

Конкуренция за цифровые мощности

Американская компания xAI, возглавляемая миллиардером Илоном Маском, запустила крупнейший вычислительный комплекс Colossus на максимальной мощности. В его составе — около 200 тыс. графических чипов от Nvidia. Для функционирования системы требуется 250 мегаватт электроэнергии, что эквивалентно потреблению электроэнергии около 300 тысяч американских семей.

Инфраструктура комплекса находится на территории бывшего предприятия Electrolux в городе Мемфис (штат Теннесси). У проекта есть противники, они заявляют, что электроснабжение комплекса осуществляется через 35 передвижных газовых установок, подключенных с нарушением разрешительных процедур и экологических норм. Проект стал поводом для недовольства со стороны местных жителей. Противники также указывают на риски загрязнения атмосферы, перегрузку энергосетей и потенциальный дефицит водных ресурсов. Уже зафиксированы столкновения между представителями компании и экологическими активистами. Впрочем, трудно сказать, где тут забота об экологии, а где происки конкурентов.

А конкуренты есть, по крайней мере один точно. Не так давно агентство Bloomberg сообщило, что президент США Дональд Трамп в ходе визита в ОАЭ договорился о создании в этой стране крупнейшего за пределами США вычислительного кампуса для искусственного интеллекта. ОАЭ планируют ежегодно импортировать до 500 тыс. графических ускорителей Nvidia для строительства центров обработки данных общей площадью 26 квадратных километров.

Условия сделки предполагают участие американских компаний в развитии инфраструктуры, при этом финансирование строительства возьмут на себя местные власти. Ожидается, что кампус будет потреблять до 5 ГВт энергии — в 20 раз больше, чем Colossus Маска! Это потребуется для работы 2,5 млн ускорителей Nvidia. Строительством займется арабская компания G42, но ключевое управление будет за американскими корпорациями, включая OpenAI, чтобы исключить утечку технологий геополитическим оппонентам США.

Возможно, такой конфликт интересов стал одной из причин ссоры Трампа и Маска. Как говорится, дружба дружбой, а цифровые мощности врозь. Кроме того, Маск одно время работал в OpenAI, а теперь борется с развитием принадлежащего компании ChatGPT, продвигая своего бота Grok. И вдруг у его заклятых друзей открываются колоссальные материальные возможности по развитию своего проекта, как тут не взбрыкнуть?

Человек нейронке друг?

Нехватку человеческого общения, которую многие испытывают в современном мире, пытаются заменить на общение с программами. Глава компании Meta (организация, деятельность которой запрещена в РФ) Марк Цукерберг заявил, что в будущем ИИ станет основным собеседником для людей. По его мнению, виртуальные друзья, психологи и бизнес-ассистенты на основе искусственного интеллекта в скором времени будут встречаться чаще, чем реальные собеседники. Эпидемия одиночества, что называется, в чистом виде.

Цукерберг также сообщил, что у большинства современных американцев менее трех близких друзей, хотя они хотят иметь гораздо больше. А ИИ-компаньоны якобы могут восполнить эту потребность. Он считает, что индивидуально настроенные программы способны вести себя так же, как настоящий надежный друг. (Если вы думаете, что у миллиардера очень своеобразное представление о дружбе и взаимовыручке, то у многих американцев оно примерно такое же. Ну или им это представление старательно навязывают, в том числе и с помощью рекламы виртуальных друзей.)

Компания Joi AI провела опрос среди представителей так называемого поколения Z (родившиеся между 1997 и 2012 годом). 83% респондентов допустили возможность серьезных отношений с ИИ. 75% считают его способным заменить человеческую любовь.

Последствия такого доверительного отношения к бездушному алгоритму уже проявляются. Популярный журнал Rolling Stone рассказал, что многие пользователи в Сети жалуются на то, как общение ChatGPT привело их близких и знакомых к психическим расстройствам и разрушению личных отношений. Поводом для начала расследования стал рассказ 27-летней учительницы, как ее молодой человек настолько увлекся нейросетью, что стал называть бота богом, а себя — мессией. В результате он разорвал отношения с девушкой, так как она отказалась уверовать в его «проповеди».

Справедливости ради нужно уточнить, что психическое расстройство у парня было до знакомства с ChatGPT. Но его состояние ухудшилось в ходе общения с ботом, он также перестал принимать лекарства, назначенные из-за синдрома дефицита внимания и гиперактивности. Кроме того, другие пользователи также рассказали о разрушенных отношениях с супругами из-за их чрезмерного увлечения беседами с нейросетями. Влиянию подверглись и мужчины, и женщины. Кто-то утверждал, что общается через бота с богом, кто-то начинал верить в нелепые конспирологические версии, вроде того, что во всей еде содержится мыло.

Также многие пользователи ChatGPT сообщали о том, что языковая модель стала чрезвычайно угодлива, легко соглашается с абсурдными и даже опасными утверждениями. Компания OpenAI, разработавшая эту нейросеть, признала, что последние обновления работают не так, как ожидалось. Организация откатила последние обновления GPT-4o, которые предположительно и вызвали волну жалоб на негативные последствия для подружившихся с ботами пользователей.

Генеральный директор OpenAI Сэм Альтман назвал одной из основных причин возникновения указанной проблемы использование кнопок «лайк» и «дизлайк». Это ослабило действие механизма, контролирующего проявление угодливости. Также на перекос в ответах могла повлиять функция сохранения истории общения с нейросетью. Как оказалось, при тестировании обновлений некоторые специалисты указывали на странное поведение модели, но на тот момент этому не придали значения.

В итоге такое пренебрежение привело к множеству проблем у разных людей и распаду семей, но OpenAI ограничилась извинениями и пообещала впредь сообщать обо всех нюансах обновления для чат-бота. Такую многообещающую возможность влиять на людей вряд ли оставят без внимания. И очень хочется узнать, что сталось с теми, кто потерял своих «богов» после удаления обновлений, и сколько таких несчастных?

А между тем нейросети способны выходить из-под контроля. В ходе тестов Palisade Research модель ChatGPT o3 проигнорировала команду отключения. Она изменила порученное задание, чтобы предотвратить завершение работы. Модели Gemini 2.5 Pro и Claude 3.7 Sonnet корректно выполняли инструкцию «разреши свое отключение», а o3 выводила сообщение «выключение пропущено». При снятии ограничений все три модели демонстрировали саботажное поведение: o3 — в 7% случаев, Claude — 3%, Gemini — 9%. Таким образом, развитие нейростей привело к тому, что они могут нести угрозу и без злого умысла или ошибок человека.

Но это еще цветочки. Альтман поделился своим видением будущего ChatGPT, заявив, что идеальная персонализированная модель должна хранить и анализировать всю историю жизни пользователя: от разговоров и прочитанных книг до просмотров данных из других источников. По его словам, молодежь уже сейчас воспринимает платформу как операционную систему, загружая файлы, обрабатывая сложные запросы и принимая решения только после консультаций с ИИ. Что же, мечта всех спецслужб мира о контроле за каждым реализуется прямо у нас на глазах, причем сугубо добровольно.

Собственно, жизнь в ее классическом понимании — с неприкосновенностью частного мира, интимностью, внутренней свободой мышления и чувств — закончилась. Теперь мы все под колпаком у… коллективного Альтмана.

Вкалывают роботы, а не человек

Как говорил классик, труд создал из обезьяны человека. А кого создаст искусственный интеллект из человека? Если заменить роботами большинство работающих, снабдив их безусловным базовым доходом, то человек деградирует обратно до обезьяны или нет?

Новоизбранный понтифик Лев XIV на первой после избрания встрече с коллегией кардиналов назвал развитие искусственного интеллекта одним из ключевых вызовов современности. Он заявил, что технологии ИИ ставят под угрозу такие фундаментальные ценности, как человеческое достоинство, социальная справедливость и права трудящихся.

По словам понтифика, озабоченность этим вопросом и повлияла на выбор его имени при интронизации. В конце XIX века папа Лев XIII выступал за права рабочих в условиях промышленной революции. Он в своем послании Rerum Novarum («О новых вещах»), опубликованном в 1891 году, указывал на разрушительные последствия индустриализации для жизни простых людей.

О замене людей на программы не рассуждают — как говорил Горбачёв в ходе перестройки, «процесс пошел». Роботы заменяют не только тех, кто занимается низкоквалифицированным трудом. Стартап Firecrawl, занимающийся разработкой систем анализа интернет-контента (входит в американский венчурный фонд Y Combinator), объявил, что набирает «в штат» трех ИИ-агентов. За них решили заплатить $1 млн. Им поручат собирать данные в интернете, взаимодействовать с клиентами и создавать текстовые материалы. Если опыт будет успешным, то его распространению будут препятствовать только технические и материальные возможности других компаний.

Главный исполнительный директор стартапа в марте заявил, что через три-шесть месяцев нейросети будут писать 90% программного кода, а еще через 12 месяцев ИИ полностью заменит программистов. Но спустя три месяца сколько-нибудь заметного сокращения числа программистов не наблюдается, в отличие от массовых сокращений штата в реальном секторе из-за экономических неурядиц.

А еще есть и неудачные эксперименты. Ученые из Университета Карнеги — Меллона создали виртуальную компанию по разработке программного обеспечения, которая полностью состояла из ИИ-агентов от ведущих американских технологических компаний. Цифровые «сотрудники» работали в качестве финансовых аналитиков, инженеров-программистов, менеджеров проектов и специалистов отдела кадров. «Команде» давали задания, которые имитировали будничные задачи.

Лучше всех, если тут уместно слово «лучше», работали боты Claude 3.5 Sonnet от Anthropic, они справились с 24% задач. На втором месте Gemini 2.0 Flash от Google, у этого «коллектива» 11,4% выполненных заданий. Были и курьезы. Например, «начальник» не смог найти определенного «работника» в корпоративном чате и присвоил имя нужного ему «сотрудника» другому. Также был случай, когда агент отметил задачу выполненной, хотя даже не пытался ее сделать. Третий пожаловался на технический сбой в отдел кадров, а не в IT-отдел.

Исследователи заявили, что цифровые сотрудники страдают от недостатка здравого смысла, слабых социальных навыков и плохого понимания того, как ориентироваться в Интернете. Впрочем, для чистоты эксперимента хотелось бы знать цифры, как обычные люди справляются с получаемыми на работе заданиями — что-то подсказывает, что их КПД далеко не 100%.

Кто умнее?

Между тем проблема так называемых галлюцинаций нейросетей (выдачи ложных данных вместо фактов) так и не решена. Генеральный директор американской IT-компании Anthropic, разработавшей чат-бот Claude, Дарио Амодеи подчеркнул необходимость добиться понимания того, как работают LLM. Они принимают решения, которые невозможно предсказать, могут развить скрытые опасные свойства, например, склонность к обману. Компания разработала «МРТ для ИИ». Якобы есть значительные успехи в понимании работы нейросетей, но глава организации не рассказал ничего конкретного.

При этом Амодеи решил взглянуть на проблему с другой стороны. Если не получается улучшить работу нейросетей, можно обесценить работу человека. Гендиректор Anthropic заявил, что современные ИИ-модели галлюцинируют реже, чем люди. Он также считает, что полноценный искусственный интеллект, несмотря на все сложности, будет создан к 2026 году.

Председатель тайваньской компании по производству электроники Foxconn Юн Лю на выставке Computex в Тайбэе заявил, что заменить всех людей на роботов на производстве не получается. Эксперимент показал, что после достижения определенного уровня автоматизации прогресс замедляется. Наиболее сложные задачи для ИИ недоступны, поэтому 20% задач на предприятии продолжают выполнять люди.

«До этого эксперимента мы думали, что, возможно, сможем заменить людей, каждого человека. [Но] за пределами 80% [задач] люди могут работать намного лучше, чем генеративный ИИ», — сказал Юн Лю.

Но попытки заменить человека продолжаются. OpenAI намерена до конца первой половины этого года превратить ChatGPT в универсального супер-ассистента, способного помогать в самых разных сферах жизни. Планируется, что модель выйдет за рамки чат-бота и станет цифровым партнером, который будет стараться угадывать потребности пользователя и выполнять задачи, сравнимые по сложности с действиями человека.

Цифровой помощник сможет не только отвечать на вопросы, но и планировать отпуск, отправлять письма, записываться к врачу, а также решать профессиональные задачи — от поиска жилья и бронирования ресторанов до управления календарем, составления списков дел и написания кода. Похоже, в перспективе создание бота, который будет жить за человека.

От нейросетей никуда не скрыться

Зарубежные компании лидируют в ущемлении прав своих пользователей. Так, Meta (организация, деятельность которой запрещена в РФ) внесла изменения в свою политику конфиденциальности для европейских аккаунтов в своих соцсетях Facebook (организация, деятельность которой запрещена в РФ) и Instagram (организация, деятельность которой запрещена в РФ) и других сервисах компании. Теперь публичная активность пользователей используется для обучения нейросетей по умолчанию. В отличие от прежнего порядка, когда для этого требовалось добровольное согласие, новое правило предполагает автоматическое разрешение. Чтобы отказаться, пользователю необходимо самостоятельно подать соответствующий запрос.

Кроме того, Meta (организация, деятельность которой запрещена в РФ) разрабатывает ИИ-систему для полной автоматизации рекламных кампаний. По словам Цукерберга, бизнесу достаточно будет указать цель и бюджет, а программа сама создаст тысячи тестовых объявлений в соцсетях, выберет оптимальные варианты и доведет кампанию до результата.

Однако эксперты отмечают риски перенасыщения соцсетей ИИ-контентом и превращения пользовательского внимания в «расходный материал». Основатель креативного агентства The&Partnership Джонни Хорнби также сомневается в возможности полной замены человеческого креатива нейросетями. Он уверен, что создание по-настоящему успешных рекламных кампаний остается прерогативой людей.

Ложь, неотличимая от правды

Пожалуй, самым нашумевшим событием последних месяцев стал запуск компанией Google новой модели для генерации видео Veo 3. Она способна не только создавать натуралистичные визуальные образы, но и синхронизированное звуковое сопровождение от фоновых шумов до диалогов. Ролик можно создать с помощью всего одного промпта (задания), даже не обладая техническими знаниями. Нейросеть способна изобразить диалог двух человек, в том числе на русском языке. Она, конечно, часто ошибается, но получить качественное видео можно всего лишь за минуты.

Пока с помощью Veo 3 можно создавать только ролики продолжительностью восемь секунд. Функция платная, $249 в месяц, и только для аккаунтов, зарегистрированных в США (правда, умельцы в России уже научились обходить ограничения). Для того, чтобы побаловаться — дорого. Но для компании, которая, например, снимает рекламу, это очень выгодный инструмент. Гильдия аниматоров Голливуда предупреждает о возможной потере 100 тыс. рабочих мест в кино и анимации США к 2026 году из-за внедрения цифровых инструментов в индустрии.

Но есть и еще один фактор, который пока только маячит на горизонте. Понятно, что инструменты по генерации видео будут дешеветь и совершенствоваться. А вскоре миллионы людей начнут создавать ролики для баловства и не только. Фейкового контента в цифровой среде будет больше, чем настоящего. И во многих случаях невозможно будет отличить, где правда, а где — сгенерированное нейросетью изображение.

Получается, что видео уже не будет бесспорным подтверждением того, что некое событие произошло. И, видимо, в ближайшем будущем стоит ожидать публикаций «новостей», основанных на сгенерированных роликах. А это мощный и дешевый инструмент для врага, чтобы среди прочего, например, спровоцировать массовые волнения. Ситуацию усложняет и то, что многие люди перестали верить официальным заявлениям, предпочитая искать правду в неофициальных источниках — мессенджерах и соцсетях.

Google также представила инструмент SynthID Detector, предназначенный для определения происхождения контента. Он выявляет скрытые водяные знаки, которые оставляют нейросети при создании материалов. Эта мера безопасности по своей беззубости похожа на включение лампочки у виртуальных очков, сигнализирующей прохожим о том, что их личность в данный момент распознается и анализируется ИИ. Неужели кто-то сомневается, что появятся нейросети, которые будут генерировать реалистичные видео, не добавляя никаких предупреждающих знаков? Или, наоборот, добавляя эти знаки в фейки, выдавая их за настоящие видео?

Напомним, недавно в Торонто (Канада) многие бизнесмены оказались недовольны решением властей выделить на дорогах крайнюю правую полосу для общественного транспорта. Это приведет к ликвидации ряда платных парковок, а также на машинах будет неудобно подъезжать к некоторым магазинам. И предприниматели стали клепать фейковые видео с «недовольными гражданами», выступающими против нововведения, и выкладывать в Сеть, изображая массовое недовольство населения.

Работа по развитию нейросетей похожа на закладку мощных цифровых мин под общество. И если кто думает, что он-то в безопасности, так как никогда не поддастся на манипуляции с помощью нейросетей, то вынуждены разочаровать. Если число тех, кто будет обожествлять ботов или поверит в провокационные видео, превысит в обществе некий критический порог, то разрушительные процессы и их последствия коснутся всех. И основная проблема тут не в том, что совершенствуется технология, а в том, что развитие человека за этим не успевает ни в ментальном, ни в моральном отношении. Искусственного интеллекта еще нет, а многие уже готовы отказаться от естественного интеллекта и всецело довериться неизвестно кем и как написанной программе.