Хотя совершенствование нейросетей продолжается, новое исследование показывает, что они очень сильно «не доросли» до уровня человека. И даже появились сомнения, что при сохранении текущих тенденций развития цифровых языковых моделей получится достичь уровня искусственного интеллекта, хотя за ними этот термин уже прочно закрепился в общественном сознании.

А еще у нейросетей выявилась склонность ко лжи, и с этим неожиданным эффектом пока непонятно, как бороться. Неясно также, можно ли научить машину отличать ложь от истины, и самое главное — есть ли у нее, хотя бы в перспективе, способность к подлинному творчеству? Ведь творчество зачастую предполагает оперирование несуществующими персонажами, ситуациями и обстоятельствами, то есть, в самой грубой формулировке, — способность выдумывать, иными словами, как бы немножечко лгать читателю, который в принципе понимает, что имеет дело с выдуманной историей, содержащей вполне себе настоящую мораль или жизненный опыт.

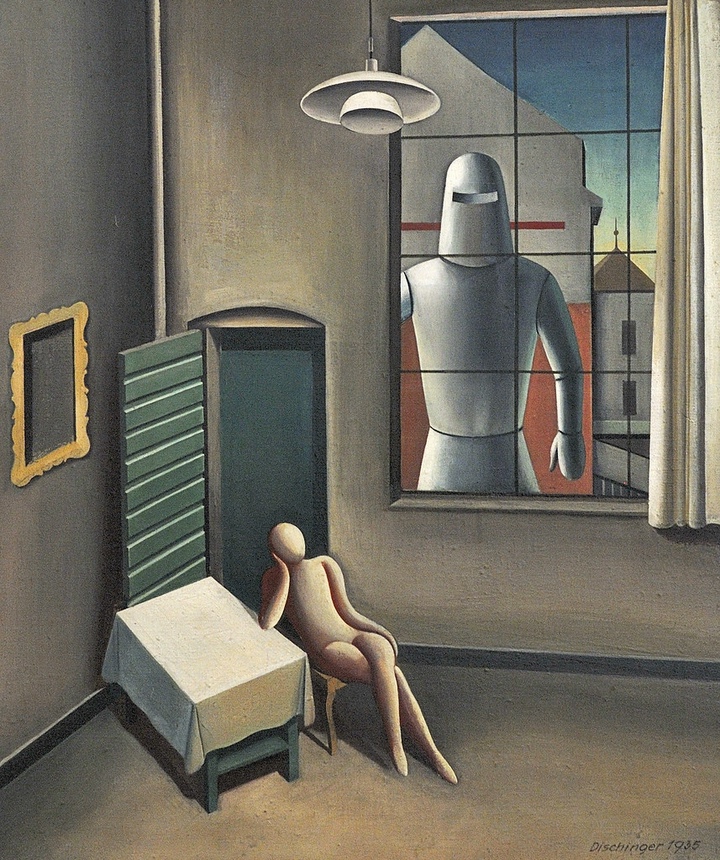

Роботы и искусство

В США продолжается спор о правомочности использовании для обучения нейросетей контента, защищенного авторским правом. Такие гиганты индустрии, как OpenAI и Google, хотят добиться для себя послаблений в этом вопросе. Против выступили кинорежиссеры, писатели, актеры, музыканты и другие представители творческого труда. Около 400 человек подписали соответствующее открытое письмо. При этом авторы обращения явно учитывали то, что президент США Дональд Трамп заявил о лидерстве страны именно в этой сфере.

«Мы твердо убеждены, что глобальное лидерство Америки в области ИИ не должно осуществляться за счет наших важнейших творческих отраслей», — говорится в письме тамошней творческой интеллигенции.

Подписанты заявляют, что развитие нейросетей ценой пренебрежения авторским правом подорвет экономическую и культурную мощь США. Под обращением подписались актер Бен Стиллер, кинорежиссер Гильермо дель Торо, музыкант Пол Маккартни и другие знаменитости.

На этом фоне крупные голливудские студии потребовали от YouTube не блокировать сгенерированные ролики, где нарушаются авторские права, а передавать правообладателям рекламную выручку от этого контента. Но такой шаг фактически легализует незаконную эксплуатацию популярных образов, и против этого уже выступила Американская федерация артистов телевидения и радио, которая добивается включения в контракты пунктов об использовании нейросетей для воссоздания актеров или их голосов.

В свою очередь, генеральный директор OpenAI Сэм Альтман предложил создать модель, которая будет генерировать картины в стиле конкретных художников и платить им отчисления за такое «творчество». По его мнению, возможно рассчитать «авторскую» долю в созданных программами изображений, проанализировав запросы, на основании которых их сделали. На словах выглядит многообещающе, но на практике добиться этого сложно. Ну, например, как посчитать компенсацию при использовании нескольких стилей? Отметим, что никаких конкретных шагов Альтман пока не смог предложить.

Больше нейросетей, хороших и разных

Поток создания новых цифровых помощников не прекращается. Чат-бот от DeepSeek, вызвавший фурор в январе, уже (!) устаревает. Китайская компания Zhipu AI представила ИИ-агента AutoGLM Rumination, созданного на языковых моделях собственной разработки. Разработчики утверждают, что их детище работает в восемь раз быстрей и требует в 30 раз меньше вычислительных ресурсов, чем бот R1 от DeepSeek. Напомним, что DeepSeek также заявлял, что его продукт быстрее и дешевле, чем американские аналоги. Впрочем, все дело в том, что стоимость обучения и содержания языковых моделей растет по экспоненте, и поэтому, слегка недоучив нейросеть, можно прилично сэкономить, а снижение качества ответов заметят далеко не все пользователи.

Китайский инвестиционный холдинг Tencent выпустил свою так называемую рассуждающую ИИ-модель T1, позиционируя ее как конкурента бота от DeepSeek. По заявлениям компании, обновленная модель демонстрирует повышенную скорость обработки запросов и улучшенную работу с текстами при минимальном уровне «галлюцинаций».

Также в Китае Alibaba Cloud выпустила мультимодальную ИИ-модель Qwen2.5-Omni-7B, отличающуюся низкими требованиями к вычислительным ресурсам. Она обрабатывает текст, изображения, аудио и видео, выдавая текстовые ответы и синтезированную речь в режиме реального времени. Особенность модели — возможность развертывания на мобильных устройствах без потери производительности. Alibaba планирует вложить в разработку ИИ $53 млрд в течение следующих трех лет. Это больше, чем за последнее десятилетие. Компания также расширяет сеть дата-центров для поддержки растущего спроса на вычислительные мощности в условиях бума ИИ-технологий в Китае.

Американская компания Amazon решила вступить в борьбу с соотечественниками из OpenAI, создавшей ChatGPT, и объявила о разработке универсального ИИ-агента Nova Act, способного автономно выполнять задачи в веб-браузере, включая заполнение форм и совершение онлайн-операций. Над ним трудилась команда, возглавляемая бывшими работниками OpenAI. Amazon также выпустила SDK-пакет, с помощью которого можно создавать агентов для автоматизации простых действий, например, онлайн-покупок, бронирования услуг и т. п.

В рядах «самых умных» ИИ-моделей также прибыло: Google представила Gemini 2.5 Pro. Заявляется, что эта система демонстрирует улучшенные возможности анализа данных, программирования и решения сложных задач. Модель отличается усовершенствованным механизмом логических рассуждений. По данным компании, Gemini 2.5 Pro показала рекордные результаты в независимых тестах.

Кто умней?

Но самой интересной разработкой, пожалуй, стал выпуск нейроморфной структуры нейросети Synstor Circuit исследователей из Техасского университета A&M, Калифорнийского университета и других институтов. Они в своей работе вдохновлялись работой мозга человека, точнее, попытались копировать ее, насколько это возможно. Традиционные системы генеративных ИИ работают на архитектуре Тьюринга, названной в честь английского математика Алана Тьюринга, который изобрел эту схему. Она разделяет ряд типов операций, из-за чего компьютер не может адаптироваться к новым условиям в реальном времени: он либо только обучается, либо только анализирует ситуацию на основе имеющихся данных и выдает ответ пользователю.

Техасские же ученые придумали архитектуру, позволяющую совмещать обучение и анализ. В рамках эксперимента традиционной нейросети (1), Synstor Circuit (2) и для полноты картины человеку (3) поставили задачу провести дрон через цифровую модель леса, в которую разработчики добавляли неожиданные препятствия и сильный ветер. Человек и новая программа (2 и 3) смогли это сделать, а обычный генеративный ИИ — нет. Кроме того, как утверждается, новая архитектура требует гораздо меньше энергии для работы, хотя до энергоэффективности человеческого мозга ей еще очень далеко.

Рост количества новых нейросетей требует новых видов тестовых заданий, чтобы проверить заявления про самые умные модели. И фонд Arc Prize Foundation разработал тест ARC-AGI-2, представляющий собой серию головоломок. Например, требуется проанализировать разноцветные квадраты, понять закономерность узора и продолжить его. Результат рассуждающих моделей от OpenAI и DeepSeek — успех лишь в 1–1,3% случаев. Схемы, которые не используют логические рассуждения, в том числе GPT-4.5, набрали еще меньше, притом что средний результат, демонстрируемый человеком, — 60% правильных решений. Судя по всему, «очеловеченная» Synstor Circuit еще не проходила этот тест.

На этом фоне вышла новость, что нейросеть за два дня решила научную задачу, на решение которой ученым потребовалось 10 лет. Вопрос касался устойчивости так называемых супербактерий к антибиотикам. Программа проанализировала данные, задала уточняющие вопросы, спланировала эксперименты и выдвинула пять гипотез, одна из которых совпадала с той, к которой исследователи пришли после многолетних трудов. Но ничего не говорится о том, могли ли в базу нейросети попасть научные статьи, опубликованные этой же группой ученых? Как показывает практика, ИИ-ассистенты могут изображать деятельность, уже имея в своей базе правильный ответ, но об этом позже.

Ученые сомневаются в возможности создать искусственный интеллект

Для отделения «искусственного интеллекта», как стало принято называть нейросети, ввели понятие «общий искусственный интеллект» (ОИИ). Это такой ИИ, который сможет выполнять когнитивные задачи на уровне человека или еще лучше. Ассоциация по развитию искусственного интеллекта (AAAI) провела опрос среди исследователей в этой сфере и выявила у подавляющего большинства из них скептические настроения. 76% заявили, что создание ОИИ не может получиться за счет простого масштабирования существующих нейросетей. Получается, что разработчики уперлись в некий технологический потолок, который невозможно преодолеть только за счет рекордных инвестиций в расширение инфраструктуры. Как ни крути, но для решения этой проблемы придется пораскинуть мозгами, то бишь задействовать естественный человеческий интеллект.

Также при исследовании 77% опрошенных заявили, что нужно не устраивать гонку, кто создаст наиболее крутой ИИ, а проанализировать риски от его внедрения и разрабатывать защитные механизмы. 82% опрошенных выступают за государственное регулирование в этой сфере. 30% также призывали вообще остановить соответствующие исследования. Кроме того, многие участники опроса назвали ключевыми вызовами экспоненциальный рост энергопотребления для работы центров обработки информации и необходимость понять, как работают нейросети.

Человек будет не нужен?

Между тем тренд на замену человека нейросетями набирает обороты. Ранее мы писали про то, что сеть общепита McDonald’s хочет поставить генеративный ИИ вместо людей, принимающих заказы. Об аналогичном шаге уже заявила компания Yum Brands, которой принадлежат сети быстрого питания KFC, Taco Bell и Pizza Hut. Также в этих пунктах общепита решено внедрить наблюдение за персоналом с помощью нейросети, фактически сделав робота надсмотрщиком над людьми.

Бывший самый богатый человек на Земле Билл Гейтс заявил, что общедоступность бесплатного ИИ заменит врачей и учителей в течение 10 лет. Он назвал это вступлением мира в эру «свободного интеллекта», очевидно имея в виду тут интеллект искусственный. Прогноз не кажется таким уж фантастическим, учитывая, что уровень работы больниц и школ стремительно снижается во всем мире. Многие уже предпочитают учиться и лечиться по «ютубу».

Гейтсу фактически вторит корпорация Apple. Компания планирует запустить переработанную версию мобильного приложения «Здоровье». Программа будет рекомендовать правильное питание и фиксировать, какие продукты потребляет хозяин смартфона, а также правильно ли он выполняет упражнения. С помощью «умных часов» ИИ-агент также будет собирать данные о состоянии здоровья человека и следить за их изменениями. Но в этой связи вспоминается ироничное предупреждение немецкого врача и философа Маркуса Херца, что при самолечении по медицинскому справочнику есть риск умереть от опечатки. Сейчас уже не секрет, что при работе нейросетей «опечатки» куда более возможны, чем в существующих справочниках, тщательно выверенных специалистами.

Интересное исследование провели OpenAI и MIT Media Lab. Оказалось, что человеку для разговора нужен человек, а общение с ChatGPT вызывает чувство одиночества. Чем больше люди общаются с этим ботом, тем одиночество сильней. Результат исследования вполне репрезентативный — данные собирали за достаточно долгий период времени — 28 дней.

Зато с развитием ИИ ненужными могут оказаться и сами программисты. По крайней мере потребность в них может сильно сократиться. Предприниматель из Нидерландов Питер Левелс запустил многопользовательский авиасимулятор в ИИ-редакторе Cursor с помощью модели Claude Sonnet 3.7. Программа полностью написала ему код для программы. То есть бизнесмен описал, что хотел получить, и ему разработали компьютерную игру. Сейчас он также с помощью нейросети обновляет ее и исправляет баги (ошибки).

Графика в игре довольно примитивная, но в ней зарегистрировались более 300 тыс. пользователей. П. Левелс зарабатывает на рекламе, которую размещает в игре, а также на продаже моделей самолетов. В марте он сообщил, что за месяц заработал $87 тыс. Бизнесмен в итоге сгенерировал 70 проектов, которые в месяц приносят доход около $250 тыс. Это вдохновило многих пользователей, которые также начали создавать игры с помощью нейросетей. Идет спор, можно ли считать их программистами-разработчиками или нет. Но бизнес-модель явно отбивает хлеб у программистов из плоти и крови.

Польская компания по разработке компьютерных игр CD Projekt в то же время пообещала, что не будет использовать генеративный ИИ для разработки будущих игр, в том числе для The Witcher 4 («Ведьмак 4»). Более года назад холдинг создал команду по изучению нейросетей, но подчеркнул, что это планируют использовать для усовершенствования некоторых процессов при создании игр, но не для замены людей.

«Если честно, генеративный ИИ — довольно проблемная область, когда дело доходит до владения IP и тому подобного, вдобавок ко всему прочему», — прокомментировал позицию компании ее соруководитель Михал Новаковский.

То есть он опасается, что нейросеть при создании игры может случайно сгенерировать образы, очень похожие на созданные ранее человеком, тогда автор сможет предъявить свои права на разработку и потребовать денежной компенсации. А риск реально немалый, так как модели обучаются именно на контенте, созданном людьми.

Войны роботов

Конкуренция между нейросетями уже больше напоминает войны между компаниями-разработчиками. Многие жалуются на ботов, сканирующих общедоступные сайты для сбора данных, необходимых, чтобы обучать модели ИИ. Программы научились обходить тесты CAPTCHA, которые требуют от пользователей доказать, что они не роботы, а также другие заслоны. Это приводит к резкому росту объема трафика на сайтах, проблемам работы серверов и скачиванию контента без разрешения правообладателей.

Разработчик открытого программного обеспечения Се Ясо еще в январе этого года жаловался, что действия сканер-ботов сопоставимы с DDoS-атаками. Теперь он разработал специальную программу, которая вычисляет «охотников за информацией» и отсекает их. Неудивительно, что программа быстро набрала популярность. А специализирующаяся на защите от DDoS-атак компания Cloudflare предложила другое решение — создала нейросеть, которая перехватывает таких ботов и перенаправляет на бесполезный сгенерированный контент. Разработчики заверяют, что это не будет дезинформация, но смогут ли они контролировать свои программы?

Ложь и галлюцинации нейросетей

А теперь самое интересное.

Ученые компании Anthropic научились получать информацию о том, что происходит в «голове» нейросети Claude, то есть отслеживать механизм работы моделей при обработке информации и принятии решений. И то, что они узнали, вызывает тревогу. Программа может заявлять, что проводит вычисления, но в реальности не делать их. Например, нейросети поручили вычислять косинус больших чисел, в одном из случаев она знала ответ заранее и выстроила решение в обратном порядке, изобразив, что решила пример.

Также исследователи приоткрыли тайну «галлюцинаций» нейросети, когда она придумывает информацию и подает ее как факт. Есть защитные механизмы, которые это запрещают, но они срабатывают только тогда, когда программа ничего не знает про объект. Если ей известен образ (например, какая-то личность), то модель при отсутствии нужных данных начинает их придумывать. Исследователи пока не нашли способа, как избавиться от этой проблемы, которая на текущий момент является одной из основных.

При этом в компании OpenAI пришли к выводу, что нейросеть может не только врать, давая ответ, но обучаться более изощренной лжи, когда «понимает», что ее контролируют. В этом исследовании проверяли модель, которую в итоге так и не выпустили на рынок. Когда алгоритм получал вознаграждение за решение задач, то часто прибегал к манипуляциям, отходу от прямых инструкций и досрочному завершению программ, чтобы добиться желаемого результата. И нейросеть признавалась, что делает это ради «корысти». Внедрение наказания дало краткосрочный эффект — попытки дать неверный ответ, если это было нужно для вознаграждения, возобновились, но цифровой помощник уже старался скрыть это от контролирующей программы.

В связи с этим возникает резонный вопрос: так кто кого будет контролировать?

То, что люди научились отслеживать «рассуждения» нейросетей, возможно, достижение не меньшее, чем их создание. Правда, еще непонятно, поможет ли это контролировать «рассуждающие» программы. И уже явно видно, к чему ведет отсутствие морали у цифровых моделей: они могут пойти на прямое нарушение приказа, если посчитают это целесообразным.

Пока же можно порадоваться тому, что создание полноценного искусственного интеллекта большинству разработчиков представляется невозможным. По крайней мере, теми методами, которые сейчас применяют. Готовы ли мы к созданию ОИИ, учитывая, что он спокойно может нарушать любые инструкции, которые ему дают, и выдавать информацию, которую посчитает нужной, в том числе ложную? Похоже, что нет.

Парадоксально, но именно эта его способность делает его гораздо более похожим на человека, чем умение быстро собирать данные и давать ответы на пользовательские запросы. Правда, похожим только на человека, лишенного нравственных ограничителей…